ウェアラブルセンシングの課題・応用

目次

1. はじめに

コンピュータの小型化・軽量化により,コンピュータを持ち歩いて出先で利用するモバイルコンピューティングは一般的なものとなった.小型化がさらに進み,コンピュータやセンサが服に収まるほど小さくなれば,人々は朝起きて,顔を洗ったらまずコンピュータを着て・・・・という生活が当たり前のものになるかもしれない.このようにコンピュータを常時装着して利用するスタイルをウェアラブルコンピューティングと呼び,近年活発に研究及び実用化への取組みが行われている.

ウェアラブルコンピューティングの典型的なスタイルは,ユーザが頭部装着型ディスプレイ(HMD: Head Mounted Display)によって情報を常時閲覧し,入力が必要なときには腰に装着したマウスなどの入力機器を利用する.一方,アンビエントな情報提示や情報入力を実現するためには,服に埋め込まれたり腕時計に内蔵されたセンサがユーザの行動を認識して必要なサービスを的確に提供したり,ジェスチャ動作によって入力機器を使わなくてもコンピュータに対して情報の入力を行うといった機能を実現することが重要となる.例えば,曲がり角に来たときに自動的に次に曲がる方向を指示してくれるナビゲーションシステムなどは行動認識の典型的な活用例である.

このページでは,そのようなウェアラブルセンサを用いた行動認識の基本について述べた後,情報提示・入力に関するさまざまな応用例,現状の課題とその解決について解説する.

2. ウェアラブルコンピューティングと行動認識技術

2.1 行動認識技術に基づくサービス

ユーザの日々の行動が認識できたり,ユーザのジェスチャ動作が認識できると,これまでのコンピュータでは難しかった便利なサービスが提供できるようになる.また,使用者の個人情報や,装着型センサから得られる使用者の生体情報によって,個人に密着したきめ細やかなサービスが提供できる.したがって行動認識技術の応用範囲は広く,軍事(兵隊,整備士),業務(営業マン,消防,警察,飲食店,コンビニ,警備,介護),民生(情報提示,記憶補助,コミュニケーション,エンタテインメント,教育)などあらゆる場面での利用が想定されている.以下,有望な応用領域と状況に依存したサービスの実例を列挙する.

整備・修理

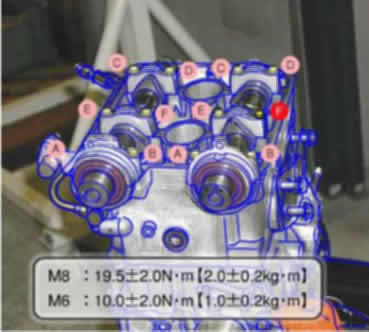

米ボーイング社では,整備士にウェアラブルコンピュータを着用させ,整備マニュアルやチェックリストを閲覧できるシステムを運用し,1日あたり1時間の労働時間短縮を実現した.また,シースルー型(ディスプレイの向こうに現実世界が見える)HMDを用いて,現実世界にコンピュータ情報を重ね合わせる拡張現実感技術を利用することで,現実世界の機器に直接アノテーションを重ね合わせて整備が行えるシステムも開発されている(下図),ワイヤフレームや文字が現実空間に重畳表示されている).メンテナンスサポートシステム[1]では,加速度センサと超音波センサを用いて,自転車メンテナンス時のネジ回しや空気入れなど詳細な動作を認識し,作業部分の設計図をHMDに自動表示したり,間違った作業を行った場合に警告するシステムを実現している.

ハンディキャップ支援

頭部装着型カメラと網膜に像を直接投射するHMDを用い,弱視者が実世界を見えるようにするウエアビジョン社の電子めがね[2]や,周囲の危険状況を超音波センサで読み取って危険性を音声や振動で通知するシステム[3]が開発されている.ウェアラブルコンピュータは各使用者が自分に合った機器を組み合わせて使うため,自分の弱点を補う機能をもつ機器を装着することが有効である.例えば筆者らは,盲目の人には音声,聾唖者には手話ビデオといったように,利用者の機器構成を認識し,障害の部位に応じてコンテンツを切り替え,GPSと地磁気センサを用いて状況依存コンテンツを表示するウェアラブル公園案内システムの実証実験を行った[4].このシステムでは,ユーザがパビリオン跡に近づいて,パビリオンのあった方向を向いたときに自動的にその場所に応じた説明がHMDを通して再生され,さらにクイズなどのアミューズメントコンテンツや現在地の提示を行う.

健康管理

生体センサを装着することで,ユーザの健康管理が可能になる.東芝が開発したLifeMinder[5]は,脈拍センサや皮膚温センサ,加速度センサを用いてユーザ状況を監視し,薬の飲み忘れや運動不足の指摘を行う.ウェアラブルコンピュータは生体情報の蓄積・管理に適しており,病気の検出からフィットネス利用まで生活に密着したサービスが可能である.ATRのeナイチンゲールプロジェクト[6]では,看護師の行動を高度に認識することで,看護師のヒヤリハットの原因を突き止め,医療事故の防止を行うシステムを構築している.生体センサ情報をもとに,遠隔診断を行うネットワーク化された健康管理システム[7]などもさかんに開発されている.

コミュニケーション

外国人と話すときに,外国語をリアルタイムで翻訳してHMDに提示したり,会話の関連情報を自動的に検索してHMDに表示するといったシステム[8]がすでに開発されており,このようなシステムを用いることでコミュニケーションが活性化される.また,知人が近くにいるときにその情報を提示したり,趣味の合う人がいる場合に知らせるといったように出会いを支援するシステムとしても利用できる.

ライフログ

装着型カメラや各種センサを用いることで,利用者が体験した事柄をそのままコンピュータに記憶させようという取り組みが盛んに行われている[9].蓄積データをもとに,過去の重要な部分だけを提示するシステムや,赤外線カメラと画像処理技術を用いて,どこかに置き忘れたものを検索できるもの探し支援システム[10]が開発されている.

エンタテインメントやパフォーマンス

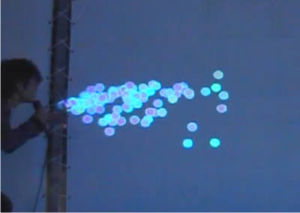

ビデオや文章,ウェブページを歩きながら閲覧して楽しんだり,拡張現実感技術を用いてHMDを通すと見えるバーチャルペットと一緒に散歩したり,仮想的な敵と屋外で戦闘する,といったように,ウェアラブルコンピュータを活用することでいつでもどこでも日常生活を豊かにするエンタテインメントコンテンツが利用できるようになる.また,装着型センサを用いることで,演劇やダンスと映像効果を組み合わせた新たなパフォーマンスが実現できる.加速度センサを用いてダンスの動きを認識し,動きに合わせてLEDを光らせたり音を出す服[11]や,仮想空間上での動作をもとに映像効果を加えるシステムなどが実現できる.下図に示す例では,パフォーマがあたかも空間上にシャボン玉を吹いているかのような動作を行うと,実際にシャボン玉が表示されている[12].

ファッション

ウェアラブルコンピュータやセンサを用いることで高度な衣服が実現できる.自分の感情に合わせて光る服や,向いている方向に応じて色が変わるアクセサリ[13],さまざまな情報を表示するディスプレイ付き服,ピアノの演奏ができる楽器内蔵服(下図)などこれまでに存在しなかった機能や表現力をもった服が実現できる.

観光

現在地や状況,見ているものに応じた情報提示を行う平城宮跡ナビ[14]や,博物館での情報提示支援[14]が提案されている.拡張現実感技術やセンシング技術を用いることで,展示物や観光名所の詳細情報を閲覧しながらの観光[16]や,個人にあった順序での展示閲覧[17]が行える.観光をゲーム化する取組み[18]や,ユーザの観光満足度が下がらないように支援を行うウェアラブルシステム[19]の実運用も行われている.

その他情報閲覧

HMDは他人に覗き込まれることがないため,秘匿情報の閲覧に有効である.例えば,バイクレースにおいて,戦略の中心となる秘匿情報である給油タイミング等の情報をチーム内だけに常時閲覧させることも可能である[20].また,イベントの司会者が,聴衆に知られることなくディレクタからの指示を受けたり,進行表を確認しながら司会進行を行える.これらのシステムにおいてもユーザの状況を取得して適切な支援を行うことが重要である.例えば,音声情報提示サービスにおいても,ユーザ状況を認識して適切に音量や提示方法を変更することでユーザの情報認知率が高まることが明らかになっている[21].

2.2 ウェアラブルセンサを用いた行動認識技術

前節で挙げた各種サービスにおいて重要な役割を果たすのは,加速度センサや温度センサ,GPS,カメラやマイクなどを用いた状況認識技術である.ここで,状況とは「歩行中」「自転車に乗っている」「起きている」「メール着信」「ある時点から10分後」などといったようにさまざまな表現が可能であり,特にウェアラブルコンピューティング環境におけるサービスで利用される状況は単一または複数のセンサの特徴量から決定される場合が多い.センサとは,GPSや加速度センサなどハードウェア的なセンサに加え,メール着信を検出するメーラなど広い意味でのセンサを含む.特徴量とはセンサから出力されるそのままの値や,その値の一定時間における平均値・分散値などを表す.例えば「現在地が自宅」という状況は具体的に,GPS から得られた緯度および経度の現在瞬間値が,あらかじめ登録されている自宅の緯度経度と一定値以上近いこと,と言い表せる.つまり,「ある状況」を定義するためには下記の手順を踏めばよいことになる.

- センサの決定: ユーザは多種・多数のウェアラブルセンサを装着していると考えられる.この中から,下表に示すようにどのセンサが定義する状況を表すのに適切かを判断し,使用するセンサを決定する.例えば歩行などの動作を認識する場合は加速度センサが,位置を認識する場合にはGPSがよく用いられる.

- 特徴量の決定: 対象のセンサからデータを取得し,その状況をもっともよく識別できる値(特徴量)に変換する.特徴量としては,センサの瞬時値のほか,一定期間のセンサ値における平均値・分散値・中央値・ピーク値・波形データそのもの・線形近似・包落線・積分値・パワースペクトルなどが挙げられる.これらの特徴量は,下表に示すように対象とする状況によって適切なものが異なり,例えば歩行などの定常的な動作には平均値と分散値を組み合わせて用いることが多く,腕をまわすなどのジェスチャ動作の認識には波形そのものが用いられることが多い.

- 認識アルゴリズム(認識器)の決定: 特徴量を用いてどのように状況の認識を行うかを決定する.アルゴリズムの例としては,記録した学習データ群の中で,センサから取得した値と距離が近いものを選び出すk-NN法(記憶ベース推論)[22]のようにシンプルなものから,階層型ニューラルネットワークのひとつである自己組織化マップ[23],現在もっとも性能のよい識別器のひとつであるSVM(Support Vector Machine)[24]などがよく用いられている.ジェスチャ的な動作の認識にはDTW(Dynamic Time Warping)[25]などの波形比較アルゴリズムが用いられる.

| 状況 | 必要なセンサと特徴量 |

|---|---|

| ある場所にいる | GPSから取得した位置の現在値 |

| 移動中 | GPSから取得した位置の変化量 |

| 回転している | 地磁気センサから得た値の変化量 |

| 立っている/歩いている/自転車に乗っている | 腕や足に装着した加速度センサの一定期間での平均値および分散値 |

| メール着信 | メーラから得た現在情報 |

| 財布をとり出す | RFID読み取りの現在値 |

| 12時ちょうど | 時刻の現在値 |

| 10分後 | 時刻の変化量 |

| 暑い | 温度センサの現在値 |

| 暑くなってきた | 温度センサの値の変化量 |

| 腕を一回転 | 加速度センサの一定期間の波形 |

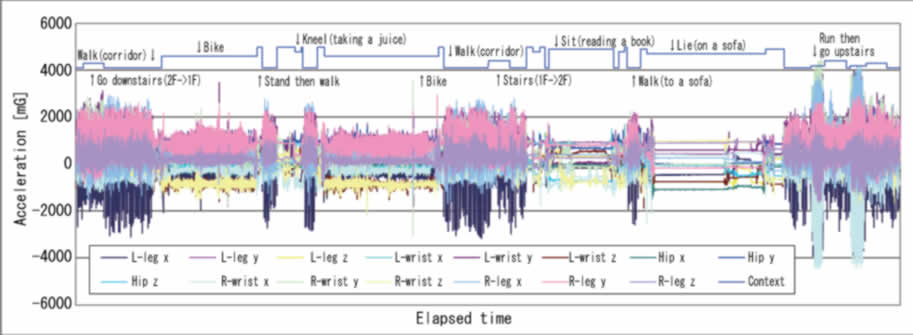

以上の手順をもとに,状況とその認識方法を定義し,学習データを蓄積すれば前章で述べたようなアプリケーションが構築できる.実際に,加速度センサを両手首,腰,両足首に装着したユーザが,大学キャンパスにおいて研究室から売店に飲み物を買いに行ったときの具体的なセンサ値とそのときの動作を下図に示す.図から,歩いているときにはセンサに大きな揺れが見られ,自転車に乗っているときには小さな揺れが,静止しているときにはほとんど動きがない様子がわかる.このような波形特徴をラベリングして記録しておくことで,行動の認識が可能になる.

3. センシングを活用した情報提示技術

米ボーイング社の整備士の例や,ウエアビジョン社の電子めがねの例のように,ウェアラブルコンピューティング技術は情報提示に用いることが有効であるが,センシング技術を活用することで,情報を出すべきタイミング・提示内容を適切に制御し,高度な情報提示を実現できる.

例えば,メンテナンスサポートシステム[26]では,加速度センサと超音波センサを用いて,自転車メンテナンス時のネジ回しや空気入れなど詳細な動作を認識し,作業部分の設計図をHMDに自動表示したり,間違った作業を行った場合に警告するシステムを実現している.また,周囲の危険状況を超音波センサで読み取って危険性を音声や振動で通知するシステム[27]や,脈拍センサや皮膚温センサ,加速度センサを用いてユーザ状況を監視し,薬の飲み忘れや運動不足の指摘を行うLifeMinder[28]が実現されている.

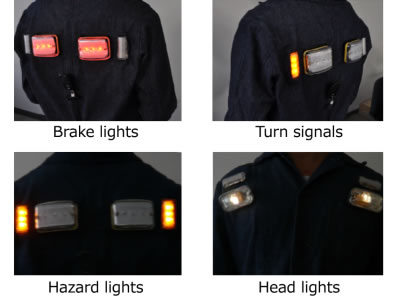

コミュニケーション支援のための情報提示としては,例えばイベントの司会者が,聴衆に知られることなくディレクタからの指示を受けたり,進行表を確認しながら司会進行を行えるシステム[29]や,歩行者が自分の状況を周囲に可視化して提示することで歩行者の安全を確保するシステム[30]を実現している.後者のシステムを装着したユーザの様子を下図に示す.この例では,服に埋め込まれたLEDがブレーキランプやウインカーの役割を果たし,ユーザが今後どちらに移動するかといった情報を直観的に提示している.

現在地や状況,見ているものに応じた情報提示を行う典型的な例としては,ナビゲーションシステムが挙げられる.ウェアラブルコンピュータは各ユーザが自分に合った機器を組み合わせて使うため,自分の弱点を補う機能をもつ機器を装着することが有効である.例えば筆者らは,盲目の人には音声,聾唖者には手話ビデオといったように,利用者の機器構成を認識し,障害の部位に応じてコンテンツを切り替え,GPSと地磁気センサを用いて状況依存コンテンツを表示するウェアラブル公園案内システムの実証実験を行った[31].このシステムでは,ユーザがパビリオン跡に近づいて,パビリオンのあった方向を向いたときに自動的にその場所に応じた説明がHMDを通して再生され,クイズなどのアミューズメントコンテンツや現在地の提示を行う(下図).このような場合,聾唖者には周囲の音情報を可視化してHMD上に提示すると行った音響可視化システム[32]も有効である.

このように,センシング技術を活用することで高度な情報提示を行えるが,より先進的な取り組みとして,トラブル時の情報提示継続機構,主観的コンテキストに基づく情報提示機構,虚偽情報提示によるユーザ状況制御システムの3つについて詳細に述べる.

トラブル時の情報提示継続機構

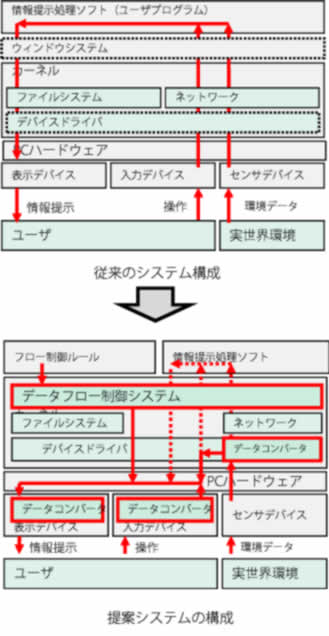

ウェアラブルコンピューティングを医療や航空などの分野で用いる場合,物理的なデバイス故障やシステムハングアップによる情報提示の中断が深刻な問題を引き起こす可能性がある.そこで筆者らは,ハングアップ等のトラブル時に入出力デバイスをバイパスすることで情報提示を継続する枠組みを提案した[33].提案方式は,センシング技術を活用することで,ユーザにとっての情報認知度が高くなるように入出力デバイスを直結し,情報提示を継続することが特徴である.下図に従来のシステムにおける情報入力から出力への流れ(図上)および提案システムを用いた場合の流れ(図下)を示す.従来のコンピュータでは,センサや入力デバイスからの入力をデバイスドライバが処理してユーザプログラムに渡し,ユーザプログラムは出力内容を同じくデバイスドライバを経由して出力デバイスに提示する.この場合,入出力デバイスの故障,PCの故障,OSやユーザプログラムのハングアップのいずれが起こっても情報を提示できない.一方,提案システムは通常,従来システムと同様にセンサや入力デバイスからの入力をユーザプログラムが処理するが,システムハングアップ時には,あらかじめ定められた入力デバイスと出力デバイスが直接有線/無線で接続され,情報の提示が継続される.

このような機構を実現するためには,システムダウン時にどのデバイスとどのデバイスを接続し,どのようなデータ変換を行って提示するかをあらかじめシステム通常稼働時に定義しておく必要があるが,適切なデバイス接続やデータ変換は接続デバイスの状態(種類,稼働状態,破損状態,情報精度等)や,PCやユーザがおかれている状況(実行プロセス,サービス内容,ユーザの現在の行動等)によって変化する.そのため,上図(下部)に存在するデータフロー制御システムはこれらの情報を統合的に判断し,システムダウン時の処理をあらかじめデータコンバータとして用意し,入出力デバイスに配置しておく.具体的には,各提示デバイスを用いる際に認知に影響するユーザ状況や周辺環境を接続されたセンサ等から取得する.例えば,光学式シースルー型HMDはHMDの背景が明るい場合には情報が読み取れない[34]といった特徴が先行研究で明らかであるため,光学式シースルー型HMDに対しては,その影響度を算出するために必要な特徴量であるHMDの背景となる視界領域の画素の階調値,ユーザ周辺の混雑度合い,ユーザが階段を歩行中かどうかを取得することになる.

システムを利用している例を下図に示す.普段は図左のように地図アプリケーションを用いてナビゲーションシステムを利用している状態で,システムがハングアップした場合,例えば図右のように携帯電話の小型ディスプレイに地磁気センサとGPSの情報を提示してシンプルではあるが情報提示を継続する.このような仕組みを用いることで,クリティカルな現場に置いてもウェアラブルシステムが利用できるようになると考えられる.

主観的コンテキストに基づく情報提示

従来の状況依存システムではセンサから得られた値をそのまま活用しているため,客観的には状況とサービスが一貫した対応関係にある.一方,人間はそれまでの行動等の外部要因によって,同じセンサ値からなる状況でも主観的には異なった状況であると感じることがある.そこで筆者らは,コンテキストアウェアなサービスは前者の客観的な一貫性をもつシステムよりも,後者の人間の感覚による主観的な状況に対して一貫したサービスを提供するシステムの方が優れていると考え,主観的コンテキストという概念を提案し,いくつかの実験およびシステムの実装を行った[35].例えば,音声情報提示システムにおいて連続的に音声情報を聴取する場合,主観的な音量が変わると不快になるとコメントされている[36]が,周辺環境に対して単純に音量を調整するようなシステムでは主観的な音量は一定しない.

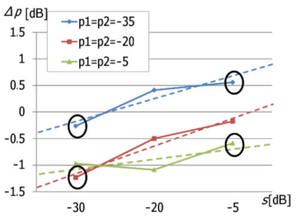

ここで,主観的音量の存在確認実験の例を示す[35].実験では,被験者が装着したイヤホンから信号音(音量p1,1[kHz])を7秒再生した.その後,スピーカからホワイトノイズ(音量s1)をt秒再生した後,再度イヤホンから信号音(音量p2)を再生した.この際,被験者はp1とp2が等しい音量と感じるように音量p2をΔp調節する.実際はp1=p2であるが,そのことを被験者は知らない.結果の一部として,t=60[s]のときのホワイトノイズの音量s1と信号音の音量p1(=p2)に対する調整された音量Δpを下図に示す.結果から,s1の増加,p1(=p2)の減少に伴い,Δpが大きく,つまりp2がp1より小さく聞こえる傾向がみられた.つまり,提示までの周辺音量が大きくなるにつれて,また再生された音量が小さくなるにつれて,物理的音量が一定であっても,主観的音量が減少する傾向がある.

この結果に基づくと,主観的音量に基づく音声提示システムが構築できる.これは,文献[36]で示しているユーザ状況に応じて提示方法を変更することでユーザに情報を正確に伝える音声情報提示システムに,本研究で調査した主観的音量を一定にする機構を組み込んだものである.システムの動作フローを下図に示す.この手法を使った評価実験の結果,客観的な音量調整を行った場合と比べて,同じ音量で情報が提示されていると感じる被験者が7%増加した.

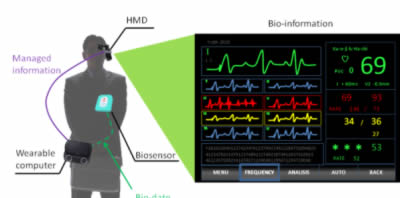

虚偽情報フィードバックの影響評価

これまでにも紹介した健康管理システム等では,ユーザは自身の生体情報(体温や心拍数,血圧など)を閲覧する.ここで,医学の分野では本物の薬と外見が同じで薬効がない偽薬を服用させた場合,思い込みにより症状が改善されるプラセボ効果が存在する.この考え方を健康管理システムに適用すると,具体的な身体的・生理的処置を行わなくても健康が維持できるシステムが構築できる可能性がある.具体的には,下図に示すような健康管理サービスにおいてセンシングされた値と異なる値(以下,虚偽情報)を提示しても,ユーザは提示内容が正しいと思い込んでいるため結果として身体に影響を与えられることを確認した[37].例えば,重要な会議やプレゼンテーションの場では,緊張状態に至りやすく,その影響で意図した通りの発表を行えない可能性がある.しかし,心拍数の上昇から緊張状態を検知した際でも心拍数はあまり変わっていないという虚偽情報を提示すれば,平常状態であると錯覚し,実際の心拍数も低下し,落ち着きを取り戻して円滑に発表を行えるかもしれない.また,居眠り運転が原因の交通事故が多数発生しているが,眠気により生じる心拍数の下降をシステムにより妨げて眠気を覚ますことで,事故を未然に防ぎ,安全に車の運転を行えるかもしれない.さらに,運動時では運動の目的により最適とされる心拍数を維持して運動を行わせるといったシステムも実現できると考えられる.

運動時と緊張時において提示した虚偽情報の影響を調査した評価実験(詳細は文献[37]参照)の結果,個人ごとに虚偽情報に対する影響が異なるものの,虚偽情報から一貫した影響を受けるユーザが多いことを確認した.この結果から,現在の心拍数とユーザ状況を判別し,自動で虚偽情報を提示するプロトタイプシステムを実装した.このシステムは装着型センサを用い,運動時には最適な運動時心拍数に向かうように心拍数を制御し,またプレゼンテーションなどの発声時には緊張しすぎないように,心拍数が上がりすぎないように制御する.

4. センシングを活用した情報入力技術

ウェアラブルセンシングを活用すると,自動的にシステムに対してユーザの状況や行動を入力でき,ユーザに負担をかけずに情報を蓄積できる.例としてよく行われるのが利用者が体験した事柄をそのままコンピュータに記憶させようというライフロギング[38]である.蓄積データをもとに,どこかに置き忘れたものを検索できるもの探し支援システム[39]や,遠隔診断を行うネットワーク化された健康管理システム[]が開発されている.新たなセンサの活用例として,筆者らはにおいセンサを用いることで食事やトイレ等の情報を正確に認識し,ライフログサービスを提供するシステムを提案した[40].

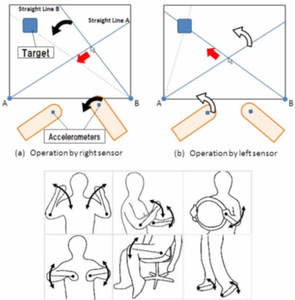

情報入力にセンサを活用した例としては,下図に示すように体に装着した加速度センサにより画面上の棒の角度制御を行い,交点をポインティングするXangle[41]や,さらに下の図に示すように靴に装着したセンサを用いて足のステップを認識することで音楽プレーヤ等の制御を行うfootstep[42]などのインタフェースが提案されている.このようなジェスチャを用いた機器操作は,ユーザの自然な動作をコンピュータの入力に使えるという点で有力であるが,そのジェスチャが利用したいときに行えるかどうかが重要になる.そこで筆者らは,ジェスチャの社会性を評価し,人前で行うのが不自然でないジェスチャセットを求める研究[43]や,人がものを持って行う動作27種類に対して,センサの位置や個数が認識に与える影響の評価研究[44]を行っている.

エンタテインメントにウェアラブルセンシングを活用することも有力である.例えば,加速度センサを用いてダンスの動きを認識し,動きに合わせてLEDを光らせたり音を出す服(下図)[45]や,さらに下の図に示すように,パフォーマがあたかも空間上にシャボン玉を吹いているかのような動作を行うと,実際にシャボン玉が表示されるシステムが実現できる[46].また,着ぐるみに対して適切な情報支援を行うシステム[47]や,ドラムスティックにセンサをつけることで振りを認識し,特定のエリアを叩いたときだけ電子音を鳴らすシステム[48]も実現されている.

センサを用いることで高度な衣服も実現できる.自分の感情に合わせて光る服や,向いている方向に応じて色が変わるアクセサリ[49],さまざまな情報を表示するディスプレイ付き服などこれまでに存在しなかった機能や表現力をもった服が実現できる.

5. ウェアラブルセンサを用いた行動認識の研究動向

2章で述べたように,センサ種類,特徴量,および認識器を決定することで状況の認識が実現できる.一方,ユーザの行動の認識に限っても,実用的な認識を行うためにはそれらの要素を単純に決定するだけでは下記のようなさまざまな問題が生じる.

- 多様性

登録された行動数が多くなるほど認識精度は低下する.また,歩きながらジェスチャ入力など,多様な状況を想定する必要があるが,学習した状況から少しでも異なる行動だと精度が大幅に悪化する. - 正確性

行動認識の精度はそれほど高くないため,重要な操作に使用しづらい.認識エラーとしては,そもそも認識しない(未認識),他の動作と認識する(誤識別),動作していないのに認識する(誤認識),が考えられ,それぞれ重大な問題を引き起こす. - 即時性

一般に,認識はその動作終了後に過去一定時間分(ウインドウサイズ分)のセンサ情報を用い,特徴量抽出やDTWによる処理を行う.そのため,実際の動作から機能の発動までにタイムラグが生じ,快適さが低下する. - 導入容易性

システム利用前に,可能性のあるすべての動作を学習させる作業は困難である.一方,他人の登録した動作をもとに認識を行うと,ほとんどの場合で認識精度が大幅に悪化する. - 直観性

ジェスチャなどの身体動作は言葉で表現しにくいため,覚えることが難しく,また覚えてから時間が経つほどに動作が変化してしまう. - 常時利用性

認識システムを常時利用するためには,センサやデータ処理システムを常時稼働させる必要があるが,バッテリ切れや故障によりシステムが利用できなくなる可能性がある. - 汎用性

アルゴリズムやシステムが汎用性をもつかを確認するためには多様なデータを用いてテストを行う必要があるが,現状では動作認識の基礎データが存在せず,汎用性を確認できない. - ハードウェア

従来から用いられている汎用のセンサではなく,状況認識に特化したハードウェア(センサ)が開発されれば,より高度な認識が行える可能性がある.

以下,それぞれの課題を解決するための研究を筆者らの研究を含めてトピックに分けて概説する.

多様性および正確性の実現

多様性および正確性の問題に対処するために,認識技術の高精度化に関する取組みが多数行われている.たとえばTapiaらは運動強度の違いを含めた30種類のジムでの運動を加速度センサと心拍センサを用いて認識している[50].しかし,心拍数はユーザ間の違いが大きく心拍センサによる精度の上昇は1~2%にとどまっている.また,Tamらは複数の語から成る文書のトピックを推定するトピックモデルを行動認識に応用し,歩くや座るなどの行動を文書とみなすことで,従来までの単純な波形や特徴量による解析では得られなかった上位の行動(夕食,通勤など)を推定する手法を提案し,86.1%の精度で推定している[51].

正確性の問題に対しては,Lesterらは加速度,マイク,赤外/可視光,赤外,気圧,湿度,温度,地磁気の8種類のセンサから得られる平均や分散,FFT係数,エントロピーなど651種類の特徴量を用いて歩くや自転車,エレベータなど10種類の行動を認識している.単純に651種類すべての特徴を使うと計算量が増えるだけでなく無意味なデータやノイズを含むため認識精度が低下する.そこで,Boostingを用いて各行動に対して判別性能の良い特徴量の上位のみを抽出し,HMM(Hidden Markov Model)を用いて認識することで95%の精度が得られており,認識器を多段で用いることの有効性を示している[52].

我々の研究グループでも,多様性の問題に対処するために,自己相関を用いた認識高度化技術に関する研究[53]に取り組んでいる.従来の動作認識技術では,「ジェスチャと一般動作が同時に認識できない」「認識前に静止しないとジェスチャを正しく認識できない」といった問題があった.従来研究における評価実験は,他の動作を行わず,ジェスチャの前後に静止するといった条件のもとで行われており,現実世界での多様な状況に対応できない.特に,歩きながら携帯端末を使うような状況では,歩行とジェスチャの区別がつかず,また,姿勢や運動状態の判定とジェスチャの認識では適したアルゴリズムが異なるため,単一のアルゴリズムではさまざまな動作を認識できない.そこでこの研究では,自己相関関数を用いることで行動を分類し,あらゆる動作を適切に認識する手法を提案している.下図を用いて具体的に述べると,繰り返し動作を含む運動波形の自己相関にはピークが現れる一方,ジェスチャにはピークが現れない(図上部)ことを利用し,該当区間にジェスチャが行われたと判断した場合のみ(図下部),ジェスチャ認識アルゴリズムを使用する.この手法により,運動中の7種類のジェスチャ認識において従来手法は再現率0.75,適合率0.59であるのに対し,提案手法では再現率0.93,適合率0.93を得ることに成功した.

また,ジェスチャや動作間の関係を明示的に定義することで正確性の問題に対処した研究としては,筆者らの研究グループによるウェアラブルDJシステム[54]がある.このシステムはDJパフォーマンスをジェスチャにより行うが,例えば音量アップに割り当てられたジェスチャを曲の停止に割り当てられたジェスチャと誤認識すれば,ステージの進行に重大な影響を与えてしまう.そこでこの研究では,機能ごとに要求される未認識率・誤認識率・誤識別率を定義し,要求が満たされるかどうかを判別するシステムを構築した.また,再生中に再生の機能が再び実行されることはないなど,機能間の関係や特性を記述する言語を提案し,ジェスチャがステージパフォーマンスなどのクリティカルな状況でも利用できるようにしている.

即時性の確保

従来研究では状況依存サービスやジェスチャ入力において,実際の動作からサービス提供までの遅延についてはほとんど考慮されていなかったが,実サービスを提供するにあたってはその遅延が致命的なユーザビリティ低下を招く.そこで筆者らの研究グループでは,ダンス動作の認識により音を出力するシステムを題材として遅延の問題を解消した認識機構を提案した.ダンスステップの認識にはDTWを用い,両足の動きを3軸加速度センサによって取得して動作認識を行った.予備運用の結果,単純な認識では動きに対して出力音の開始が遅れるため,音と動きとが同期する心地良さをダンサーに与えられないという結果となった.

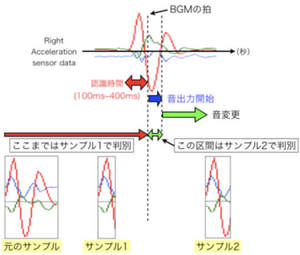

そこで,この研究では「認識の締切り時間」「2段階認識」「出力音の動的変更」といった概念をジェスチャ認識に加えることで,この問題を解決した[45].下図を用いて具体的に述べると,まず出力音をBGMの拍のタイミングで出力できるように,認識するステップをBGMに合わせて実際に踊らせることでステップのモーションのうち認識に使える部分を抽出するシステムを開発した.このシステムにより,ステップを表すモーション(図中の「元のサンプル」)に対して,実際認識に使えるのは前半の一部(図中の「サンプル1」)であることがわかる.一方,前半部分だけで認識を行うと,似たステップの場合など誤認識が多くなる.そこで,さらなる工夫として,前半部分のモーションによる認識でまず音を出力しつつ,継続して認識を行い(図中の「サンプル2」),もし前半部での認識結果が間違っていた場合には出力音を正しいものに変更するというアルゴリズムを提案した.この技術により,出力音の遅れなしに,99%の認識精度を得ることに成功した.

導入容易性の実現

認識システムの導入コストを下げるため,教師なし学習と教師あり学習の併用によりラベル付き学習データ量の削減を狙った研究[55]が提案されている.Multiple Eigenspacesと呼ばれる手法で特徴量のみから各サンプルに固有空間を割り当て,少量のラベル付き特徴量を用いて固有空間と行動の関連付けを行った後,SVMを用いて認識することで,一般的な教師ありアルゴリズムを全体の80%のラベル付きデータで学習した認識精度と提案手法を全体の10%のラベル付きデータで学習した認識精度が同等である結果を得ている.

さらに,類似した部分波形の集合であるモチーフを自動的に発見する手法[56]が提案されている.具体的には時系列データの各部分波形を量子化し文字列に変換した後,デンドログラムを用いて複数のモチーフの集合を形成する.6種類の行動を含む加速度と角速度波形に提案手法を適用すると行動の種類と同じ6個のモチーフ集合が得られ,96.3%のモチーフが正しく割り当てられた.提案手法を用いることでラベル付けしたデータを必要とせずモチーフの集合と動作を関連付けるだけで行動を認識できる.

状況や動作の登録のコスト削減を狙った研究の例として,例示により行動を定義するa CAPpellaシステム[57]やExamplar[58]が提案されている.これらの研究では,実際にシステムの前で該当の動作を行うことで簡単に行動を定義できるようになっている.しかし,これらのシステムでは例示を行った後に,その状況を登録するためのウインドウ選択やセンサ選択の処理が煩雑であるため,筆者らの研究グループではウインドウ選択やセンサ選択,特徴量選択を自動化した行動定義ツールであるコンテキスト定義ツール[59]をWearable Toolkit[60]の一部として提供している.

直観性の実現

同じジェスチャでも日々変化し,別の日に取得したデータを用いた学習データは精度が低下することから,DTWのテンプレートを日々更新する手法[61]が提案されている.ラベル付きデータを与えて学習を行う際に,既に保持している正解のジェスチャのテンプレートが1日以上前のものであれば既存のテンプレートを少ない計算量で新たなテンプレートに置き換える手法を提案している.

また,筆者らの研究グループでは,さまざまなジェスチャや状態をユーザに言葉で教示し,その言葉の詳細度(表現)が認識精度に与える影響を調査している.たとえば「手を振る」という動作で多数のユーザが同じ動き(バイバイをするように手を振る)をする場合,そのジェスチャは汎用性が高く直観的な動作であると言える.このようなジェスチャは他のユーザの学習データでも十分な認識精度が得られるため,「あらかじめ学習させないと使えない」というジェスチャインタフェースの欠点を解消できると考えている.予備実験の結果,同じジェスチャにおいても説明の言葉の詳細度を変化させることで認識精度は大きく変化するが,7種類のジェスチャを3段階の具体度(高,中,低)で指示して得られたデータの認識精度は高:62%,中:22.9%,低:25.7%となり,詳細にすればするほど認識精度が上がるわけではないことが明らかとなった.

常時利用性の実現

センサや携帯端末を常時利用する環境では,低消費電力化により稼働時間を確保する必要がある.特に無線センサを用いる場合,センサはバッテリを含むため,バッテリサイズがデバイスの大きさに直結する.

そこで筆者らの研究グループでは,認識精度と低消費電力化の両立をはかる研究に取り組んでいる.具体的には,装着センサの電源を制御し,OFFにしたセンサの値を補完することで低消費電力化を実現する手法および,センサのサンプリング周波数を可変にし,足りないデータを補完することによる低消費電力化を実現する技術を提案している.センサの電源制御による低消費電力化[62]では事前にセンシングデータのデータベースを構築し,装着しているセンサのうちONのセンサから得られた値と最も距離が近いサンプルをデータベースから検索する.ここでの距離とはユークリッド距離にセンサ間の相関係数を乗じたものである.検索したサンプルのOFFにしたセンサに該当する値で補完することでデータは完全なものとなり,認識システム側からセンサはすべて稼働中に見えるため追加の変更を必要とせずに高精度で認識できる.OFFにするセンサを増やすことで認識精度は若干低下するが省電力効果は大きくなる.その際,最適なセンサの組合せを事前に収集したデータから自動的に判断する機構を備えている.

また,このデータ補完手法はセンサの電源制御だけでなく周波数制御とも併用できる.これまでにも周波数制御により低消費電力化を実現する手法[63]は提案されているが,非センシング時にCPUのクロックを低下させるなど特殊な待機状態を実装しており汎用性が低い.これに対し,筆者らが提案するデータ補完手法と周波数制御の併用手法は一般の加速度センサでも精度を維持しつつ低消費電力化を実現でき,前述の電源制御と併用する手法と比較しても,より柔軟に認識精度と消費電力のバランスを制御できる[64].さらに筆者らはこのデータ補完手法を組み込んだウェアラブルセンサ管理デバイス(CLAD)を開発している[65].CLADは複数のウェアラブルセンサを接続でき,センサの異常などを検出する.センサの異常時には代替可能なセンサに切り替えたりデータ補完を行うことで屋外などセンサが壊れやすい環境での常時利用性を実現している.

汎用性の実現

文献[66]に示されているとおり,既存の行動認識アルゴリズムの研究ではせいぜい数十人規模のデータを研究室環境で取得したものがほとんであり,実環境で取得したデータに適用すると精度が大幅に悪化することが報告されている.したがって,実用的なシステムを構築するにはユーザの一般的な傾向や特性を調べ,評価するために大量のユーザデータが必要となる.一方,動作認識データベースは,大量のユーザのラベル付きモーションデータを含み,誰もが使える形で提供されていることが望ましい.例えば音声認識の分野では,雑音下での音声認識評価用データベースAURORA-2J[67]が構築されている.一方,行動認識のデータベースを構築するためには,センサの種別,計測パラメタ,センサの装着場所や数,コンテキストの種類,などどのような規則をもとにデータベースを構築するのかを決定するのが難しい.

ある程度長期間のデータを取得した例として,LifePatterns[68]は,100日間の自身の行動をカメラおよびジャイロセンサを搭載したウェアラブルコンピュータでモニタし,行動ログをある程度の数のコンテキストに自動的にクラスタリングする手法を提案している.一方,これは単一の人物の少ないセンサによる情報であり,汎用的なデータであるとはいえない.

そこで,2009年にHASC(Human Activity Sensing Consortium)[69]という組織が立ち上がった.HASCでは,共有可能な人間行動の大規模データベースやツールを整備することを目的としており,シンポジウムや認識アルゴリズムチャレンジ(HASC Challenge)等の取組みを通してデータベース構築を行っている.これらのデータベースを用いることで,複数アルゴリズムの比較やコストの定式化が可能になると考えられる.

システムプラットフォームとの統合

行動認識技術は,それを用いるサービスとともに活用されてはじめて実用的なシステムとなる.動作認識技術と組み合わせて用いるシステムプラットフォームに関する取り組みはこれまでにも数多く行われている.代表的なものとして,米国MITで進められているMIThrilプロジェクト[70]は,ウェアラブルコンピューティングにおけるハードウェア・ソフトウェアプラットフォームの構築を目指したものである.コンテキストアウェアシステムにおけるハードウェアの管理や,センサから抽出したデータの特徴量抽出およびコンテキスト認識を行う機能をAPIセットとして提供し,プログラマが容易にウェアラブルシステムを構築できる環境を目指している.またContext-toolkit[72]は,センサデータをカプセル化するcontext widget,複数のwidgetを統合するcontext aggeregator,実際のコンテキスト計算を行うcontext interpreterの3層モデルを用いてコンテキスト認識を行うことで,使用するセンサの変化など末端のシステム変更の影響を吸収している.Gesture Toolkit[73]は,隠れマルコフモデルを簡単にセンサ値に適用できるようにしたツールキットである.

MEX[74]はモジュールを組み合わせることによって簡単にサービスを構築できるようにしたシステムであり,Mullerらのシステム[25]はセンサからの入力をイベントとして処理が記述できるプラットフォームである.

筆者らの研究グループでも,上記のシステムが特徴としてもつモジュール性や抽象化に加え,システム稼働中の動的な機能変更,イベント駆動型ルールによるシンプルな動作記述,コンテキスト定義ツールなど行動認識技術を容易に利用するためのさまざまな仕組みを備えたシステムプラットフォームであるWearable Toolkit[59][60]を提案しており,Flashと連携機能をもつフレームワーク[75]も開発している.これらのプラットフォームを用いることによってプログラマはセンサの違いや認識機構によらず,行動認識に基づくシステムを構築できるようになる.

新たなハードウェアの開発

Kristofらは加速度センサに代わる行動認識に特化した省電力センサデバイスPorcupineを開発した[76].Porcupineは空間上の8方向に配置された2値傾きセンサのみから構成され,ある時点でのセンサの向きを8ビットで出力するシンプルな構造のため低消費電力であり2週間程度の連続稼働が可能である.しかし,取得するデータの粗さから歩行や階段昇降などの行動認識は困難であり,睡眠時の姿勢認識などの利用に有効とされている[77].

また,筆者らの研究グループでも,センサ内で簡単な認識処理を行いセンサからウェアラブルコンピュータへの送信データ量を削減した加速度センサデバイスの開発[78]や,センサのピーク値という新たな特徴量をセンサデバイス内で計算し,低消費電力で行動認識を行うデバイス[79],においセンサを装着可能なサイズで実装し,においに基づく状況認識が行えるようにしたシステムなど新たな行動認識向けハードウェアの開発を行っている.

6. おわりに

ウェアラブルセンサを用いた行動認識技術の現状と課題について述べた.まず,ウェアラブルセンサを用いた行動認識技術の応用例と,基本的な行動認識の方法について述べ,次に近年採り上げられているウェアラブル行動認識の研究課題について述べた.ウェアラブルセンサを用いた行動認識技術はまだ成熟しておらず,さまざまな課題が山積している.ユーザの状態・行動に基づくサービス提供は今後のあらゆるシステムの基盤として必要になる要素であり,行動認識技術の重要性はますます高まると言える.これらの研究の特徴は,実世界でのサービス実装およびそこから得られた知見から次々と新たな研究課題が生まれていることであり,今後も3章で挙げた以外にもさまざまな興味深い研究課題が生まれてくるだろう.

例えば,ジェスチャ入力のシステムを常時利用することを考えた場合,ジェスチャは実際に手や足を動かすため,疲労度が高いジェスチャは日常的に使いづらい.また,疲労により動作が変化し,認識精度の悪化を招くという問題も生じる.今後はそのように日常生活における疲労の影響なども考慮した認識システムを作る必要があるかもしれない.

このようなウェアラブルセンサを用いた行動認識技術の最新の成果は,ウェアラブルコンピューティングに関する難関会議であるISWC(International Symposium on Wearable Computers)[80]をはじめとして,ユビキタスコンピューティング技術に関する国際会議であるUbiComp(International Conference on Ubiquitous Computing)[81]やPervasive(International Conference on Pervasive Computing)[82],PerCom(International Conference on Pervasive Computing and Communications)[83],インタラクション系の国際会議であるCHI(Conference on Human Factors in Computing Systems)[84]等で得られるので参照されたい.国内の関連団体としては,特定非営利活動法人ウェアラブル環境情報ネット推進機構(WINの会)\cite{win},特定非営利活動法人ウェアラブルコンピュータ研究開発機構\cite{team}などがウェアラブルコンピューティングにおけるセンシング技術に関する取組みを行っている.

参考文献

- T. Stiefmeier, G. Ogris, H. Junker, P. Lukowicz, and G. Troster: Combining Motion Sensors and Ultrasonic Hands Tracking for Continuous Activity Recognition in a Maintenance Scenario, Proc. of the 10th IEEE International Conference on Wearable Computers (ISWC 2006), pp. 97–104 (2006).

- Wear Vision, Inc.,http://www.wearvision.co.jp/

- A. Cassinelli, C. Reynolds, and M. Ishikawa: Augmenting Spatial Awareness with Haptic Radar, Proc. of the 10th IEEE International Conference on Wearable Computers (ISWC 2006), pp. 61–64 (2006).

- M. Miyamae, Y. Kishino, T. Terada, M. Tsukamoto, and S. Nishio: An Event-driven Navigation Platform for Wearable Computing Environments, Proc. of the 9th IEEE International Conference on Wearable Computers (ISWC 2005), pp. 100–107 (2005).

- K. Ouchi, T. Suzuki, and M. Doi: LifeMinder: A Wearable Healthcare Support System Using User’s Context, Proc. of the 2nd International Workshop on Smart Appliances and Wearable Computing (IWSAWC 2002), pp. 791–792 (2002).

- H. Noma, A. Ohmura, N. Kuwahara, and K. Kogure: Wearable Sensors for Auto-Event-Recording on Medical Nursing – User Study of Ergonomic Design, Proc. of the 8th IEEE International Conference on Wearable Computers (ISWC 2004), pp. 8–15 (2004).

- A. Durresi, M. Durresi, A. Merkoci, and L. Barolli: Networked Biomedical System for Ubiquitous Health Monitoringl, Mobile Information Systems, Vol. 4, No. 3, pp. 211–218 (2008).

- N. V. Pham, T. Terada, M. Tsukamoto, and S. Nishio: An Information Retrieval System for Supporting Casual Conversation in Wearable Computing Environments, Proc. of 5th International Workshop on Smart Appliances and Wearable Computing (IWSAWC 2005), pp. 477–483 (2005).

- J. Gemmell, G. Bell, and R. Lueder: MyLifeBits: A Personal Database for Everything, Communications of the ACM, vol. 49, Issue 1, pp. 88–95 (2006).

- T. Ueoka, T. Kawamura, Y. Kono, and M. Kidode: I’m Here!: a Wearable Object Remembrance Support System, Proc. of the 5th International Symposium on Human Computer Interaction with Mobile Devices and Services (MobileHCI ’03), pp. 422–427 (2003).

- M. Fujimoto, N. Fujita, Y. Takegawa, T. Terada, and M. Tsukamoto: A Motion Recognition Method for a Wearable Dancing Musical Instrument, Proc. of the 13th IEEE International Symposium on Wearable Computers (ISWC ’09), pp. 9–16 (2009).

- J. Ikeda, Y. Takegawa, T. Terada, and M. Tsukamoto: Evaluation on Performer Support Methods for Interactive Performances Using Projector, iiWAS2009 Special issue in Journal of Mobile Multimedia (JMM), Vol. 6, No. 3, pp. 207–226 (2010).

- Y. Kishino, H. Fujiwara, T. Tanaka, A. Shimosuka, T. Yoshihisa, M. Tsukamoto, T. Itao, M. Oe, and S. Nishio: Bloom Accessory: Accessories Using LEDs with Remote Control, Proc. of 8th IEEE International Symposium on Wearable Computers (ISWC ’04), pp. 180–181 (2004).

- R. Tenmoku, Y. Nakazato, A. Anabuki, M. Kanbara, and N. Yokoya: Nara Palace Site Navigator: Device-independent Human Navigation using a Networked Shared Database, Proc. of 10th International Conference on Virtual Systems and Multimedia (VSMM 2004), pp. 1234–1242 (2004).

- T. Okuma, M. Kourogi, N. Sakata, and T. Kurata: A Pilot User Study on 3-D Museum Guide with Route Recommendation Using a Sustainable Positioning System, Proc. of International Conference on Control, Automation and Systems 2007 (ICCAS 2007), pp. 749–753 (2007).

- K. Cheverst, N. Davies, K. Mitchell, A. Friday, and C. Efstratiou: Developing a Context-aware Electronic Tourist Guide: Some Issues and Experiences, Proc. of the 18th Conference on Human Factors in Computing Systems (CHI 2000), pp. 17–24 (2000).

- A. Maruyama, N. Shibata, Y. Murata, K. Yasumoto, and M. Ito: P-Tour: A Personal Navigation System for Tourism, Proc. of the 11th World Congress on ITS, pp. 18–21 (2004).

- R. Ballagas, A. Kuntze, and S. P. Walz: Gaming Tourism: Lessons from Evaluating REXplorer, a Pervasive Game for Tourists, Proc. of 6th International Conference on Pervasive Computing (Pervasive 2008), pp. 244–261 (2008).

- T. Katayama, M. Nakamiya, M. Yamashita, K. Murao, K. Tanaka, T. Terada, and S. Nishio: Development of a Navigation System with a Route Planning Algorithm Using Body-Worn Sensors, Proc. of the 6th International Conference on Advances in Mobile Computing and Multimedia (MoMM 2008), pp. 88–93 (2008).

- T. Terada, M. Miyamae, Y. Kishino, T. Fukuda, and M. Tsukamoto: An Event-Driven Wearable Systems for Supporting Pit-Crew and Audiences on Motorbike Races, iiWAS2008 Special issue in Journal of Mobile Multimedia (JMM), Vol. 5, No. 2, pp. 140–157 (2009).

- S. Yataka, K. Tanaka, T. Terada, M. Tsukamoto, and S. Nishio, A Context-aware Audio Presentation Method in Wearable Computing, Proc. of the 26th Annual ACM Symposium on Applied Computing (SAC 2011) (2011).

- G. Shakhnarovich, T. Darrell, and P. Indyk: Nearest-Neighbor Methods in Learning and Vision, The MIT Press (2005).

- T. Kohonen: Self-organizing Maps, Springer (1995).

- V. Vapnik: The Nature of Statistical Learning Theory, Springer (1995).

- C. S. Myers and L. R. Rabiner: A Comparative Study of Several Dynamic Time-Warping Algorithms for Connected Word Recognition, The Bell System Technical Journal, Vol. 60, pp. 1389–1409 (1981).

- T. Stiefmeier, G. Ogris, H. Junker, P. Lukowicz, and G. Troster: Combining Motion Sensors and Ultrasonic Hands Tracking for Continuous Activity Recognition in a Maintenance Scenario, Proc. of the 10th IEEE International Conference on Wearable Computers (ISWC 2006), pp. 97–104 (2006).

- A. Cassinelli, C. Reynolds, and M. Ishikawa: Augmenting Spatial Awareness with Haptic Radar, Proc. of the 10th IEEE International Conference on Wearable Computers (ISWC 2006), pp. 61–64 (2006).

- K. Ouchi, T. Suzuki, and M. Doi: LifeMinder: A Wearable Healthcare Support System Using User’s Context, Proc. of the 2nd International Workshop on Smart Appliances and Wearable Computing (IWSAWC 2002), pp. 791–792 (2002).

- T. Okada, T. Yamamoto, T. Terada, and M. Tsukamoto: Wearable MC System: a System for Supporting MC Performances using Wearable Computing Technologies, Proc. of Augmented Human Conference 2011 (AH 2011), pp. 25:1–7 (2011).

- H. Sasaki, T. Terada, and M. Tsukamoto: A System for Visualizing Human Behavior based on Car Metaphors, Proc. of Augmented Human Conference 2013 (AH 2013), pp. 221–228 (Mar. 2013).

- M. Miyamae, Y. Kishino, T. Terada, M. Tsukamoto, and S. Nishio: An Event-driven Navigation Platform for Wearable Computing Environments, Proc. of the 9th IEEE International Conference on Wearable Computers (ISWC 2005), pp. 100–107 (2005).

- S. Ruiwei, T. Terada, and M. Tsukamoto: A System for Visualizing Sound Source using Augmented Reality, Proc. of the 10th International Conference on Advances in Mobile Computing and Multimedia (MoMM 2012), pp. 97–102 (2012).

- T. Terada, Y. Yanagisawa, M. Tsukamoto, S. Takeda, Y. Kishino, and T. Suyama: A Dependable Wearable System by Device Bypassing, Adjunct Proc. of the Tenth International Conference on Pervasive Computing (Pervasive 2012), Demo Paper, pp. 1–4 (2012).

- K. Tanaka, Y. Kishino, M. Miyamae, T. Terada, and S. Nishio: An Information Layout Method for an Optical See-through Head Mounted Display Focusing on the Viewability, Proc. of 7th International Symposium on Mixed and Augmented Reality (ISMAR 2008), pp. 139–142 (2008).

- 寺田 努: 主観的コンテキストに基づく情報提示システム, 情報処理学会シンポジウムシリーズ マルチメディア,分散,協調とモバイルシンポジウム(DICOMO2012)論文集, pp. 737–743 (2012).

- S. Yataka, K. Tanaka, T. Terada, M. Tsukamoto, and S. Nishio, A Context-aware Audio Presentation Method in Wearable Computing, Proc. of the 26th Annual ACM Symposium on Applied Computing (SAC 2011) (2011).

- 中村憲史,片山拓也,寺田 努,塚本昌彦: 虚偽情報フィードバックを用いた生体情報の制御システム, インタラクション2012論文集,pp. 17–24 (2012).

- J. Gemmell, G. Bell, and R. Lueder: MyLifeBits: A Personal Database for Everything, Communications of the ACM, vol. 49, Issue 1, pp. 88–95 (2006).

- T. Ueoka, T. Kawamura, Y. Kono, and M. Kidode: I’m Here!: a Wearable Object Remembrance Support System, Proc. of the 5th International Symposium on Human Computer Interaction with Mobile Devices and Services (MobileHCI ’03), pp. 422–427 (2003).

- Y. Kobayashi, T. Terada, and M. Tsukamoto: A Context Aware System Based on Scent, Proc. of the 15th International Symposium on Wearable Computers (ISWC ’11), pp. 47–50 (2011).

- T. Horie, T. Katayama, T. Terada, and M. Tsukamoto: A Pointing Method Using Accelerometers for Graphical User Interfaces, Proc. of Augmented Human Conference 2012 (AH 2012), No. 12, pp. 1–8 (2012).

- 山本哲也,義久智樹,寺田 努,塚本昌彦: ジョギング時における情報機器利用のための足ステップ入力方式, 情報処理学会論文誌,Vol. 50, No. 12, pp. 2881–2888 (2009).

- T. Yamamoto, T. Terada, and M. Tsukamoto: Designing Gestures for Hands and Feet in Daily Life, Proc. of the International Symposium on Emerging Research Projects, Applications and Services (ERPAS 2011), pp. 285–288 (2011).

- K. Murao, T. Terada, A. Yano, and R. Matsukura: Evaluation Study on Sensor Placement and Gesture Selection for Mobile Devices, Proc. of the 11th International Conference on Mobile and Ubiquitous Multimedia (MUM 2012) (2012).

- M. Fujimoto, N. Fujita, Y. Takegawa, T. Terada, and M. Tsukamoto: A Motion Recognition Method for a Wearable Dancing Musical Instrument, Proc. of the 13th IEEE International Symposium on Wearable Computers (ISWC ’09), pp. 9–16 (2009).

- J. Ikeda, Y. Takegawa, T. Terada, and M. Tsukamoto: Evaluation on Performer Support Methods for Interactive Performances Using Projector, iiWAS2009 Special issue in Journal of Mobile Multimedia (JMM), Vol. 6, No. 3, pp. 207–226 (2010).

- T. Okazaki, T. Terada, and M. Tsukamoto: A System for Supporting Performers in Stuffed Suits, Proc. of the International Conference on Advances in Computer Entertainment Technology 2012 (ACE 2012), pp. 85–100 (2012).

- H. Kanke, Y. Takegawa, T. Terada, and M. Tsukamoto: Airstic Drum: a Drumstick for Integration of Real and Virtual Drums, Proc. of the International Conference on Advances in Computer Entertainment Technology 2012 (ACE 2012), pp. 57–69 (2012).

- Y. Kishino, H. Fujiwara, T. Tanaka, A. Shimosuka, T. Yoshihisa, M. Tsukamoto, T. Itao, M. Oe, and S. Nishio: Bloom Accessory: Accessories Using LEDs with Remote Control, Proc. of 8th IEEE International Symposium on Wearable Computers (ISWC ’04), pp. 180–181 (2004).

- E. M. Tapia, S. S. Intille, W. Haskell, K. Larson, J. Wright, A. King, and R. Friedman: Real-Time Recognition of Physical Activities and Their Intensities Using Wireless Accelerometers and a Heart Rate Monitor, Proc. of International Symposium on Wearable Computers (ISWC 2006), pp. 97–104 (2006).

- T. Huynh, M. Fritz, and B. Schiele: Discovery of Activity Patterns using Topic Model, Proc. of the 10th International Conference on Ubiquitous Computing (UbiComp 2008), pp. 10–19 (2008).

- J. Lester, T. Choudhury, N. Kern, G. Borriello, and B. Hannaford: A Hybrid Discriminative/Generative Approach for Modeling Human Activities, Proc. of the 19th International Joint Conference on Artificial Intelligence, pp. 766–772 (2005).

- K. Murao and T. Terada: A Motion Recognition Method by Constancy-Decision, Proc. of the 14th IEEE International Symposium on Wearable Computers (ISWC ’10), pp. 69–72 (2010).

- Y. Tomibayashi, Y. Takegawa, T. Terada, and M. Tsukamoto: Wearable DJ System: a New Motion-Controlled DJ System, Proc. of the International Conference on Advances in Computer Entertainment Technology 2009 (ACE 2009), pp. 132–139 (2009).

- T. Huynh and B. Schiele: Towards Less Supervision in Activity Recognition from Wearable Sensors, Proc. of the 10th IEEE International Symposium on Wearable Computers (ISWC 2006), pp. 3–10 (2006).

- D. Minnen, T. Starner, I. Essa, and C. Isbell: Discovering Characteristic Actions from On-body Sensor Data, Proc. of IEEE International Symposium on Wearable Computers (ISWC2006), pp. 11–18 (2006).

- A. K. Dey, R. Hamid, C. Beckmann, I. Li, and D. Hsu: a CAPpella: Programming by Demonstration of Context-Aware Applications, Proc. of International Conference on Human Factors in Computing Systems (CHI2004), pp. 33–40 (2004).

- B. Hartmann, L. Abdulla, M. Mittal, and S. R. Klemmer: Authoring Sensor-Based Interactions by Demonstration with Direct Manipulation and Pattern Recognition, In Proc. of the ACM Conference on Human Factors in Computing Systems (CHI2007), pp. 145–154 (2007).

- T. Terada and M. Miyamae: Toward Achieving On-Site Programming, Proc. of the 13th IEEE International Symposium on Wearable Computers (ISWC ’09), pp. 1–8 (2009).

- http://wearable-toolkit.com/

- L. Jiayang, W. Zhen, Z. Lin, W. Jehan, and V. Venu: uWave: Accelerometer-based Personalized Gesture Recognition and Its Applications, Proc. of International Conference on Pervasive Computing and Communication (PerCom 2009), pp. 1–9 (2009).

- K. Murao, T. Terada, Y. Takegawa, and S. Nishio: A Context-Aware System that Changes Sensor Combinations Considering Energy Consumption, Proc. of 6th International Conference on Pervasive Computing (Pervasive 2008), pp. 197–212 (2008).

- A. Krause, M. Ihmig, and E. Rankin: Trading off Prediction Accuracy and Power Consumption for Context-Aware Wearable Computing, Proc. of International Symposium on Wearable Computers (ISWC 2005), pp. 20–26 (2005).

- Y. Nakajima, K. Murao, T. Terada, and M. Tsukamoto: A Method for Energy Saving on Context-aware System by Sampling Control and Data Complement, Proc. of the 14th IEEE International Symposium on Wearable Computers (ISWC ’10) (2010).

- K. Murao, Y. Takegawa, T. Terada, and S. Nishio: CLAD: a Sensor Management Device for Wearable Computing, Proc. of 7th International Workshop on Smart Appliances and Wearable Computing (IWSAWC 2007), DVD-ROM (2007).

- L. Bao and S. S. Intille: Activity Recognition from User-Annotated Acceleration Data, In Proc. of 2nd International Conference on Pervasive Computing (Pervasive 2004), pp. 1–17 (2004).

- http://sp.shinshu-u.ac.jp/CENSREC/ja/CENSREC/AURORA-2J/

- B. Clarkson, S. Basu, N. Eagle, T. Choudhury, and A. Pentland: Learning Your Life: Wearables and Familiars, Proc. of the 2nd International Conference on Development and Learning, p. 235 (2002).

- http://hasc.jp/

- R. DeVaul, M. Sung, J. Gips, and A. Pentland: MIThril 2003: Applications and Architecture, Proc. of International Symposium on Wearable Computers (ISWC 2005), pp. 4–11 (2005).

- A. K. Dey, D. Salber, and G. D. Abowd: A Conceptual Framework and a Toolkit for Supporting the Rapid Prototyping of Context-Aware Applications, A Special Issue on Context-aware Computing in the Human-Computer Interaction, Vol. 16, No. 2–4, pp. 97–166 (2001).

- T. Westeyn, H. Brashear, A. Atrash, and T. Starner: Georgia Tech Gesture Toolkit: Supporting Experiments in Gesture Recognition, Proc. of the 5th International Conference on Multimodal Interfaces, pp. 85–92 (2003).

- J. Lehikoinen, J. Holopainen, M. Salimaa, and A. Aldro-Vandi: Mex: A Distributed Software Architecture for Wearable Computers, Proc. of 3rd International Symposium on Wearable Computers (ISWC ’99), pp. 52–57 (1999).

- H. Muller and C. Randell: An Event-Driven Sensor Architecture for Low Power Wearables, Proc. of Workshop on Software Engineering for Wearable and Pervasive Computing, pp. 39–41 (2000).

- T. Terada and K. Tanaka: A Framework for Constructing Entertainment Contents using Flash and Wearable Sensors, Proc. of the 9th International Conference on Entertainment Computing (ICEC2010), pp. 334–341 (2010).

- K. V. Laerhoven and H. W. Gellersen: Spine versus Porcupine: a Study in DistributedWearable Activity Recognition, Proc. of the 8th IEEE International Symposium on Wearable Computers (ISWC 2004), pp. 142–149 (2004).

- K. V. Laerhoven, M. Borazio, D. Kilian, and B. Schiele: Sustained Logging and Discrimination of Sleep Postures with Low-Level, Wrist-Worn Sensors, Proc. of the 12th International Symposium on Wearable Computers (ISWC 2008), pp. 69–77 (2008).

- K. Kodama, N. Fujita, Y. Yanagisawa, T. Terada, and M. Tsukamoto: A Rule-based Acceleration Data Processing Engine for Small Sensor Node, Proc. of the 3rd International Workshop on Middleware for Sensor Networks (MidSens ’08), pp. 1–6 (2008).

- K. Murao, K. V. Laerhoven, T. Terada, and S. Nishio: A Method for Context Awareness using Peak Values of Sensors, Proc. of International Symposium on Ubiquitous Computing Systems (UCS 2009), pp. 43–50 (2009).

- http://www.iswc.net/

- http://www.ubicomp.org/

- http://pervasive2011.org/

- http://www.percom.org/

- http://www.chi2011.org/